ChatGPT feiert bald seinen zweiten Geburtstag. Aus ChatGPT 3 ist mittlerweile ChatGPT 4o geworden. Kinder werden groß.

Chatbots wie ChatGPT, Claude, Perplexity, Gemini, Grok und Co. faszinieren uns und liefern beeindruckende Ergebnisse. Aber wenn es um Wissensfragen geht, lief und läuft es nicht immer rund: Denn oft gab es fette inhaltliche Fehler in den Antworten und so manche Quellenangabe war manchmal schlichtweg „erfunden“.

Chatbots mit besseren Antworten

Aber ändert sicht das gerade? Viele haben den Eindruck, dass ChatGPT und Co. inzwischen bessere Ergebnisse zu liefern scheinen und auch passendere Quellen nennen. Ist ja nicht ganz unwichtig, wenn man sie als Unterstützung fürs Studium, Arbeit und Co. nutzen will. Aber ist das wirklich so? Werden sie tatsächlich besser bei Wissensfragen?

Wir können ihnen auf jeden Fall eher vertrauen als noch zu Anfang. Die Antworten werden wirklich besser. Aber ein blindes Vertrauen ist trotzdem nicht angebracht: Chatbots machen auch heute noch Fehler.

Viele von uns haben den Eindruck, ChatGPT ist vetrauenswürdiger, weil sich zwischen dem ChatGPT 3 aus den November 2022 und dem ChatGPT 4o im Sommer 2024 einiges getan hat. Der Chatbot versteht meine Fragen besser, antwortet präziser und ausführlicher und ist inzwischen auch aktuell.

Das hilft sehr, weil ChatGPT so zum Beispiel den EM von diesem Jahr bereits kennt, sogar dass Spanien gegen England gespielt hat. Vor zwei Jahren undenkbar.

Chatbots werden genauer und überprüfen vieles noch mal

Schnellere, direktere Antworten schaffen da natürlich schon mal mehr Vertrauen bei uns. Und es gibt tatsächlich bei Wissensfragen deutlich weniger Fehler, sie arbeiten genauer, sagen Studien. Und weil die meisten Chatbots heute auch Zugriff auf aktuelle Infos haben, hilft das auch, dass viele Antworten eher stimmen als früher.

ChatGPT und einige andere Chatbots wenden einen Kniff an: Wenn sie ihre Antwort bereits fertig haben, überprüfen sie noch mal selbst, ob alles zu stimmen scheint, nötigenfalls auch durch einen Abgleich im Nethz. Sie überprüfen die wichtigsten Fakten noch mal. Das merkt man.

Das gilt eigentlich für alle Chatbots, ob sie nun ChatGPT, Gemini, LLama, Grokq, Perplexity oder Claude heißen.

Und wichtig fürs unser Vertrauen, Chat GPT liefert inzwischen Quellen, sagt woher es was weiß, allerdings nur auf Nachfrage.

Besseres Verständnis

Alles in allem: Deutlich bessere Ergebnisse als noch vor einem Jahr und erst recht als vor zwei Jahren, das belegen gleich mehrere Studien, die in diesem Bereich gemacht werden.

Doch kein Lob ohne „Aber“: Gerade bei den Quellenangaben, also woher hat die KI das Ergebnis, da gab‘s ja in der Vergangenheit viele Diskussionen, auch weil ChatGPT sich manchmal sogar Infos und Quellangaben ausgedacht hat, die nur echt klangen. Ist das ist jetzt anders?

Chatbots wissen nichts, sie suchen nach Wahrscheinlichkeiten

Was man unbedingt verstehen muss: Chatbots „wissen“ nichts, sie berechnen Wahrscheinlichkeiten, während sie die Antworten erzeugen.

Was ist die wahrscheinlich richtige Antwort? Chatbots wie ich, basierend auf Modellen wie GPT-4, haben kein „Wissen“ im herkömmlichen Sinne. Stattdessen basieren sie auf großen Datenmengen und berechnen Wahrscheinlichkeiten, um Antworten zu generieren.

Früher war es tatsächlich so, dass ChatGPT keine Quellen für seine Aussagen lieferte. Das lag daran, dass es als Sprachmodell darauf trainiert wurde, menschenähnlichen Text zu generieren, ohne dabei auf einzelne Quellen im Internet zurückzugreifen.

Chatbots nennen nun auch Quellen

Inzwischen hat sich das geändert. OpenAI, die Entwickler von ChatGPT, haben die Modelle weiterentwickelt und neue Funktionen hinzugefügt. So kann ChatGPT in neueren Versionen auf Anfrage Quellen für seine Aussagen nennen.

Wichtig für mich und uns alle, man kann inzwischen die Quellen dann direkt anklicken, sehr hilfreich um tiefer einzusteigen und auch zum prüfen, was hat mir die KI daraus gesucht, schafft ja auch Vertrauen.

Allerdings ist die Genauigkeit dieser Quellenangaben noch immer ein Herausforderung. Es kommt gelegentlich vor, dass ChatGPT Quellen erfindet oder falsch zuordnet.

Insgesamt muss man aber sagen, ChatGPTs Antworten sind inzwischen akkurater, wo sich ChatGPT nicht sicher ist, formuliert es der Chatbot auch entsprechend. Sagt zum Beispiel „Die wissenschaftliche Studienlage ist ungenau“ oder „Es sind nicht genügend seriöse Informationen zugänglich“. Solche Transparenz schafft natürlich auch Vertrauen.

Studien belegen die verbesserte Leistung

Der Eindruck, dass die Ergebnisse besser werden, der täuscht nicht: Es gibt auch Studien, die belegen, dass mittlerweile mehr Vertrauen in ChatGPT und CO gerechtfertigt sind.

Eine Studie der Harvard University hat Anfang des Jahres die Genauigkeit und Vollständigkeit der Antworten von großen Sprachmodellen wie ChatGPT im Vergleich zu menschlichen Experten in spezifischen Bereichen wie der Augenheilkunde. Die Ergebnisse zeigten, dass ChatGPT in der Lage ist, präzise und umfassende Antworten zu liefern. Diese Studio bezog sich noch auf ChatGPT 4, mittlerweile gibt es die weiter entwickelte Version 40.

Allerdings hat ChatGPT noch keine klare Vorstellungen von den eigenen Grenzen. Manchmal wäre es besser, ChatGPT würde sagen: Das ist zu komplex, dazu kann ich keine Antwort geben.

Eine andere wissenschaftliche Studie des Beth Israel Deaconess Medical Center aus Israel belegt: ChatGPT ist in der Diagnostik, also beim Erkennen von Krankheiten oder Störungen in der Medizin, heute bereits besser als der Mensch, wohlgemerkt besser als Mediziner. Die Studie ist vom April 2024.

Die Ergebnisse waren beeindruckend. Der Chatbot übertraf in mehreren Bereichen die Leistung der menschlichen Ärzte. Insbesondere bei der klinischen Begründung und dem Stellen von Diagnosen zeigte der Chatbot eine bemerkenswerte Genauigkeit.

ChatGPT kommuniziert wie ein Mensch

Es gibt auch eine Studie der Stanford University, die zeigt, dass gerade die neuste Version von ChatGPT mit uns so kommuniziert, als wäre sie ein Mensch. Das erzeugt natürlich ein – sagen wir mal – „vertrauensvolles Umfeld“. Aber diese Studie sagt nichts darüber aus, ob und wie richtig die Antworten sind.

Zwei Punkte sind wichtig

A) Studien brauchen Zeit – und bis sie fertig sind, haben die Chatbots schon wieder große Schritt in der Weiterentwicklung gemacht.

Und B) egal wie erstaunlich die Leistungen der KIs. Schaffen viel mehr als vor zwei Jahren . Sie machen trotzdem Fehler . Machen aber Menschen natürlich auch, selbst wenn ich unter meinen Freunden, die schlausten, die alles lesen und zu wissen scheinen, was frage, kann es sein, dass die mal falsch liegen.

Wir entwickeln ja auch ein Gespür dafür, wann ich ich mich auf eine Antwort bei Freunden und Familie verlassen kann, und wann die selber nicht so ganz wissen wovon sie reden. Aber warum hab ich mit KIs ähnliche Probleme? Warum machen die überhaupt Fehler: Die bekommen doch alle Infos, die online verfügbar sind und vergessen nix.

Problem: Auch KI wird mit Unsinn trainiert

Und genau das ist das Problem, könnte man sage. Denn im Netz steht halt auch jede Menge Blödsinn oder zumindest sehr unterschiedliche Antworten auf die selber Frage 😉

ChatGPT und die anderen KI-Chatbots bekommen eben nicht nur die beste Fachliteratur der Welt zu „lesen“, dann könnten sie keine Fragen zur Aktualität beantworten, sondern sie haben auch studiert, was sie im Internet steht. Also Artikel auf Webseiten, Youtube-Videos, aber auch Postings auf Social Media.

Die Wissenschaft ist sich keineswegs immer einig, und auf Social Media und im Web werden durchaus auch viele Falschbehauptungen, Desinformationen und einfach auch Fehler verbreitet. Die Aufgabe einer KI ist es, all diese Informationen zu sammeln, zu bewerten – der Fachartikel hat mehr Gewicht als 100 Behauptungen in Postings – und sich dann einen Eindruck zu machen.

Das ist nicht leicht, das kennen wir doch von uns selbst: Je mehr Experten wir zu einem Thema hören, desto schwieriger wird es doch, sich festzulegen, was stimmt.

Das führt dann schon mal zu Fehlern und die anderen liegen dann oft an uns, wie wir fragen.

ChatGPT und Co: Richtig fragen ist wichtig

Weil wir doof fragen? Bekommen wir doofe Antworten?

Ein bisschen schon. 🙂 Naja, sagen wir mal, wir sorgen oft für Missverständnisse, weil wir unpräzise Formulierungen beim Fragen werden.

Zum Beispiel, wenn ich frage: Was sind die besten Eissorgten? ChatGPT weiß dann nicht, was die Frage bedeuten soll. Was ist gemeint? Die besten Eissorten in der Lieblings-Eisdiele, in einem Land, am beliebtesten bei Kindern? Die Frage ist viel zu unspezifisch und ohne Kontext nicht objektiv zu beantworten.

Ein anderes Beispiel: Wenn ich einfach nur frage: „Wer ist Michael Müller“, kann der Chatbot unmöglich wissen, wen ich meine – und selbst wenn, kann es schon mal passieren, dass einzelne Stationen des Lebenslaufs durcheinander geraten. Man muss dann genauer fragen: „Was weißt Du über den Politiker Michael Müller aus dem Saarland?“ Das hilft.

Also wenn wir etwas von einer KI wissen wollen sollten wir bei jeder Frage beachten, dass wir so präzise wie möglich sind und auch sagen, was genau wir wissen wollen – und auch, wie ausfürhlich die Informationen sein sollen.

Der Prompt ist entscheidend für die Qualität

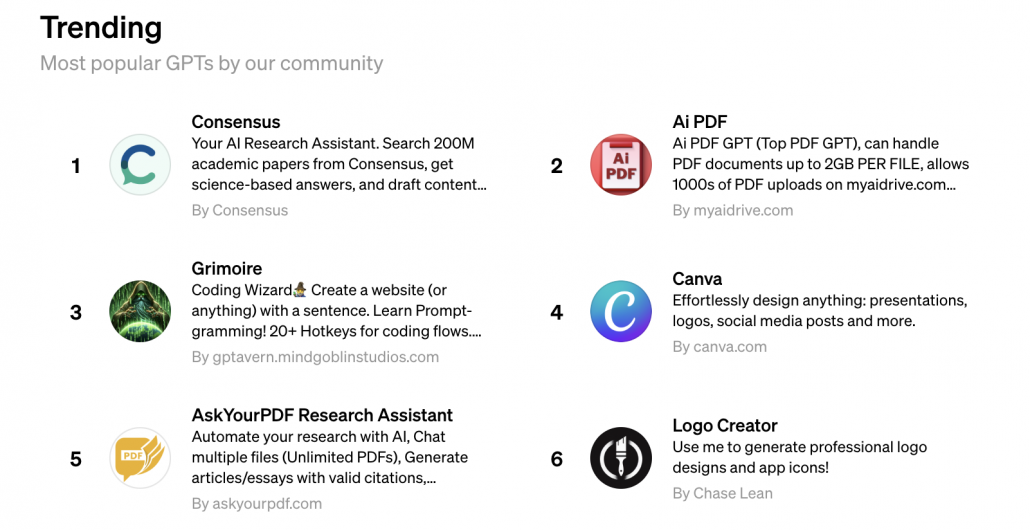

Ich mach das so, bei der Formulierung der Frage etwas mehr Arbeit, aber dafür danach weniger, weil ich nicht mehrfach nachfragen muss. Das ist nen Problem bei ChatGPT, man bekommt zwar die Quellen muss man aber fragen, ich nutze daher häufig Perplexity.

Ein KI Chatbot haben viele nicht auf dem Zettel, findet man aber einfach im Netz, den Link packe ich gerne in die Shownotes zu den anderen. Entwickelt von ehemaligen i OpenAI-also ChatGPT-Entwickklern Perplexity legt großen Wert darauf, viele Quellen zu nennen und die Suchergebnisse zusammenzufassen.

Das ist ein wesentlicher Vorteil für die Recherche, da es Transparenz und Überprüfbarkeit der Informationen ermöglicht. Die Quellangaben lassen sich direkt anklicken, damit man bei Bedarf noch mal in die Tiefe gehen kann und nutzt nicht nur ein trainiertes Modell, sondern sucht auch online nach Informationen und versucht Fakten und Behauptungen überprüft – was zu einer höheren Genauigkeit führt. Da vertrauen ich schon mehr auf die Antworten, prüfe aber auch noch mal nach.

Sag deinem Chatbot doch, wenn er Fehler macht…

Was mache ich denn, wenn ich erkenne, dass ein Chatbot offensichtlich oder nur womöglich einen Fehler gemacht hat?

Chatbots machen Fehler. Das wird in Zukunft zwar besser, aber es wird nie ganz auszuschließen sein,. Aber wenn Du einen Fehler entdeckst oder einen Verdacht hast, dann sag einfach: „Das kann nicht stimmen“ – und begründe es kurz.

Du wirst staunen: Oft sagen die Chatbots dann „Du hast recht“, und korrigieren ihre Antwort oder präzisieren sie. Die Entwickler sind sich darüber im Klaren, dass die Chatbots noch Fehler machen und bringen ihnen dabei, souverän damit umzugehen, im Zweifel noch mal nachzuforschen oder auch den Nutzern zu sagen, wenn die Faktenlage nicht eindeutig ist.

Wir können den KIs nicht komplett vertrauen, aber mehr als vor zwei Jahren, man sollte selbst hinterfragen, oder nachbohren und auf die Quellen bestehen. Aber ich vermute, das Vertrauen wird wachsen.

Bedeutet also: Die Antworten von Chatbots werden besser, sind aber noch nicht perfekt – und wir können selbst Einfluss darauf nehmen, dass wir bessere Antworten bekommen, indem wir ausführliche Fragen stellen.

Chatbots können die Antworten von Chatbots überprüfen

Also mehr Vertrauen als Früher aber vielleicht nicht die wichtige Hausarbeit oder nen Bewebrungsgespräch auf die eine KI Antwprt setzen.

Ein Trick hab ich noch: Wer auf Nummer Sicher gehen will, nimmt die Antwort des einen Chatbots und fragt einen anderen, ob das stimmt. Da die Chatbots unterschiedliche Stärken haben, lassen sich so Fehler oft ausmerzen.

Vergleichsstudien zu großen Sprachmodellen:

Eine Studie untersuchte die Genauigkeit und Vollständigkeit der Antworten von großen Sprachmodellen wie ChatGPT im Vergleich zu menschlichen Experten in spezifischen Bereichen wie der Augenheilkunde. Die Ergebnisse zeigten, dass ChatGPT in der Lage ist, präzise und umfassende Antworten zu liefern, obwohl es noch Einschränkungen in Bezug auf das Bewusstsein für eigene Grenzen gibt.

https://www.sciencedaily.com/releases/2024/04/240401142448.htm

Genauigkeit von Chatbots bei der Zitierung von Fachartikeln:

Eine Untersuchung der Genauigkeit von Chatbots, insbesondere ChatGPT, bei der Zitierung wissenschaftlicher Artikel zeigte, dass es noch Herausforderungen gibt, insbesondere in der korrekten und vollständigen Zitierung von Quellen. Diese Studie hebt die Notwendigkeit weiterer Verbesserungen in der Zuverlässigkeit und Genauigkeit von Chatbots bei der wissenschaftlichen Kommunikation hervor.

https://link.springer.com/article/10.1007/s44217-024-00138-2

Leistungsfähigkeit von Chatbots im klinischen Umfeld:

Eine Studie von Beth Israel Deaconess Medical Center verglich die klinische Entscheidungsfindung von Chatbots mit der von Ärzten. Diese Forschung zeigte, dass Chatbots in bestimmten klinischen Szenarien die Leistung von Ärzten übertreffen können, was auf die potenziellen Vorteile von Chatbots als Unterstützungstools in der medizinischen Diagnose hinweist.

https://www.sciencedaily.com/releases/2024/04/240401142448.htm

Perplexity:

www.perplexity.com

Claude AI: