Stell dir vor, du hörst die Stimme deines Lieblingsstars – aber es ist nicht wirklich seine Stimme. KI macht’s möglich.

Künstliche Intelligenz revolutioniert die Art und Weise, wie wir Sprache wahrnehmen und erzeugen. Erfahre, wie KI menschliche Stimmen lernen und täuschend echt imitieren kann – inklusive Emotionen.

Von Sprachsynthese zu Stimmenimitation

Die Erzeugung künstlicher Sprache ist keine neue Erfindung. Seit Jahrzehnten gibt es Sprachsynthese-Systeme, die geschriebenen Text in gesprochene Sprache umwandeln. Diese Systeme basieren auf einer Datenbank aufgenommener Sprachfragmente, die zu Wörtern und Sätzen zusammengefügt werden. Das Ergebnis klingt oft roboterhaft und unnatürlich.

Doch mit dem Aufkommen von Deep Learning und neuronalen Netzen hat sich das Feld rasant weiterentwickelt. Moderne KI-Systeme sind in der Lage, nicht nur Sprache zu generieren, sondern auch den Klang einer bestimmten Person zu imitieren – mit verblüffender Genauigkeit.

Das Geheimnis liegt in den Daten

Um eine Stimme zu synthetisieren, braucht die KI vor allem eines: Daten, und zwar jede Menge davon. Je mehr Audiomaterial einer bestimmten Person zur Verfügung steht, desto besser kann die KI deren stimmliche Eigenheiten erfassen und nachahmen.

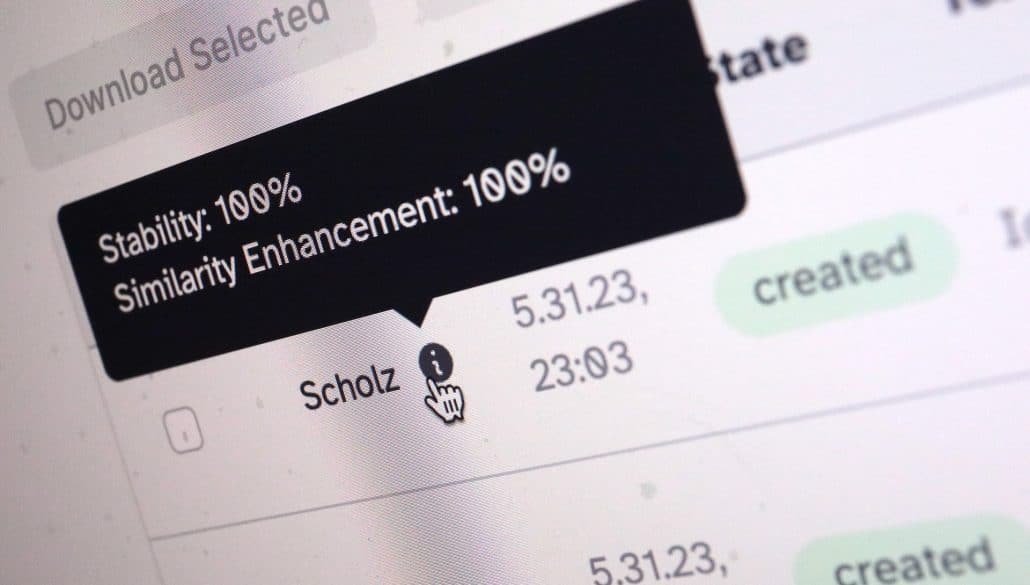

Das Training erfolgt meist mit neuronalen Netzen, insbesondere sogenannten „Generative Adversarial Networks“ (GANs). Dabei lernen zwei Netzwerke quasi im Wettstreit: Ein Generator-Netz erzeugt Audiodaten, die der Originalstimme möglichst ähnlich sein sollen. Ein Diskriminator-Netz versucht, die generierten Daten von echten zu unterscheiden. Durch viele Trainingsrunden verbessern sich beide Netzwerke immer weiter.

Emotionen erwecken die Stimme zum Leben

Eine menschliche Stimme transportiert weit mehr als nur den gesprochenen Text. Betonung, Tonfall, Sprechgeschwindigkeit – all das verleiht dem Gesagten eine emotionale Färbung. Und genau diese Nuancen machen eine synthetisierte Stimme erst wirklich überzeugend.

Moderne Stimmenmodelle sind in der Lage, solche Feinheiten zu erfassen und wiederzugeben. Dafür analysieren sie nicht nur die Audiodaten selbst, sondern auch den Kontext, in dem sie gesprochen wurden. Mithilfe von Sentiment-Analyse und Textverständnis kann die KI die passende emotionale Färbung auswählen und auf den generierten Text übertragen.

Ein Blick in die Zukunft

Die Stimmensynthese hat in den letzten Jahren enorme Fortschritte gemacht. Aktuelle Systeme wie WaveNet von Google oder Real-Time Voice Cloning von Baidu erzeugen Ergebnisse, die von echten Stimmen kaum noch zu unterscheiden sind.

Doch die Entwicklung geht weiter. Forscher arbeiten daran, die benötigte Datenmenge zu reduzieren und die Flexibilität der Modelle zu erhöhen. Bald könnten wir KI-Systeme haben, die nach dem Hören weniger Sätze eine Stimme imitieren und beliebige Texte darin vorlesen können – inklusive lebensechter Emotionen.

Die Möglichkeiten sind faszinierend: Virtuelle Assistenten mit der Stimme eines geliebten Menschen, personalisierte Hörbücher oder sogar „Gespräche“ mit historischen Persönlichkeiten. Zugleich wirft die Technologie auch ethische Fragen auf, etwa nach dem Schutz der Persönlichkeitsrechte. Eines ist sicher: Stimmensynthese wird in Zukunft eine immer größere Rolle spielen – und wir sollten sowohl die Chancen als auch die Herausforderungen im Blick behalten.